随着DeepSeek的火爆,无论是网页版还是API接口,都面临着巨大的用户压力,导致服务器频繁出现繁忙情况,影响了使用体验。

为了更高效、稳定地使用DeepSeek,如果你的电脑配置较好,且对数据隐私或定制化有需求,本地部署无疑是一个值得考虑的选择。

为什么选择本地部署?

对于大多数用户来说,使用在线版本已经足够,但如果你有以下需求,本地部署将大大提升体验:

数据隐私保护:本地部署确保数据完全留在自己控制之下,避免云端泄露风险。

定制化需求:根据自身业务需求灵活调整模型参数和功能,增强模型的适用性。

离线使用:不再受服务器繁忙的困扰,随时随地都能使用DeepSeek。

降低长期成本:长期使用本地部署比云服务更加经济,特别是需要高频调用的场景。

本地部署DeepSeek R1的简单步骤

以下是最简洁、清晰的本地部署教程,帮助你快速启动DeepSeek R1。

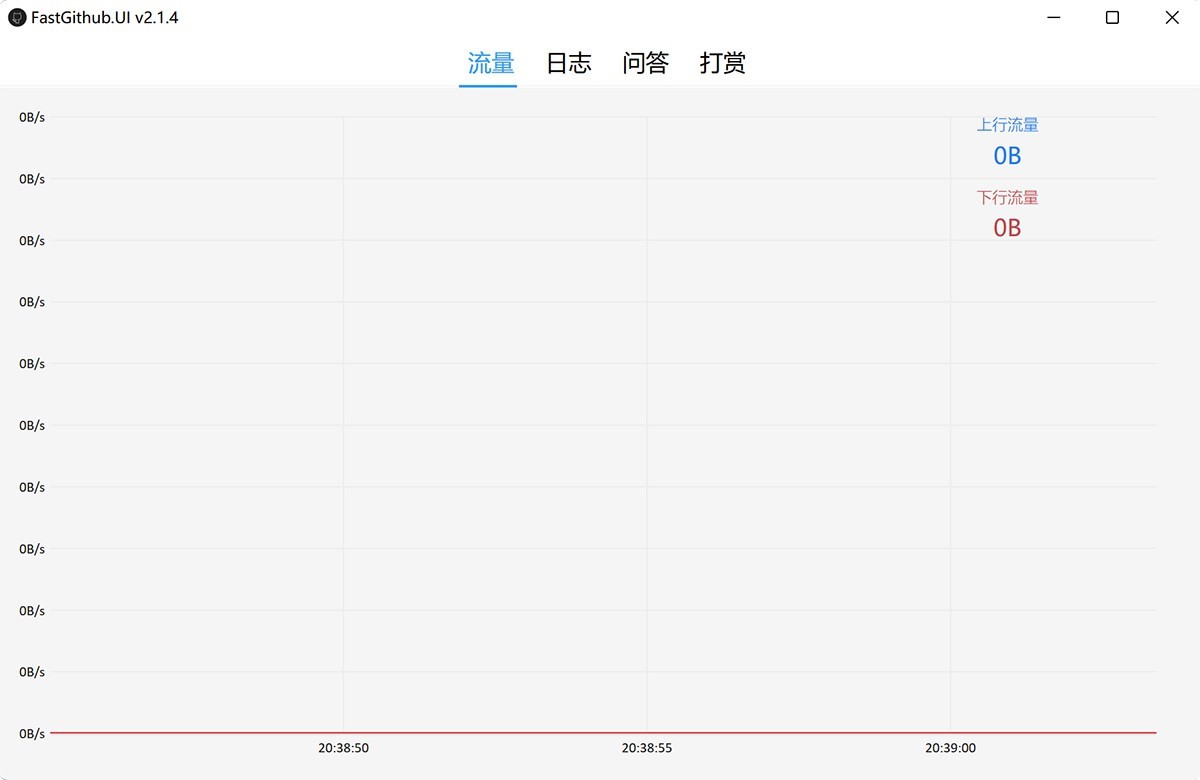

步骤一:下载并安装Olama

Olama是一个本地化大模型管理工具,支持Windows、macOS和Linux操作系统。它将帮助你将复杂的云端大模型轻松迁移到本地计算机。

在浏览器中搜索“Olama”并进入官网。

点击下载按钮。

根据你的操作系统选择合适的安装包。

下载完成后,双击安装文件,按照提示完成安装。

步骤二:选择DeepSeek模型

打开Olama,访问官网上的模型选择页面。

在“Models”选项中,选择DeepSeek-R1模型。

在下拉框中,选择1.5B版本,该版本参数适中,适合大多数场景,且对计算机性能要求较低。

复制模型安装命令:ollama run deepseek-r1:1.5b。

步骤三:安装并运行模型

打开命令行终端,粘贴刚刚复制的命令并执行。

后台会自动下载模型,等待下载完成即可开始使用。

部署完成后,可以输入/help或者/测试模型是否正常运行。此时,已可以直接与DeepSeek进行对话。

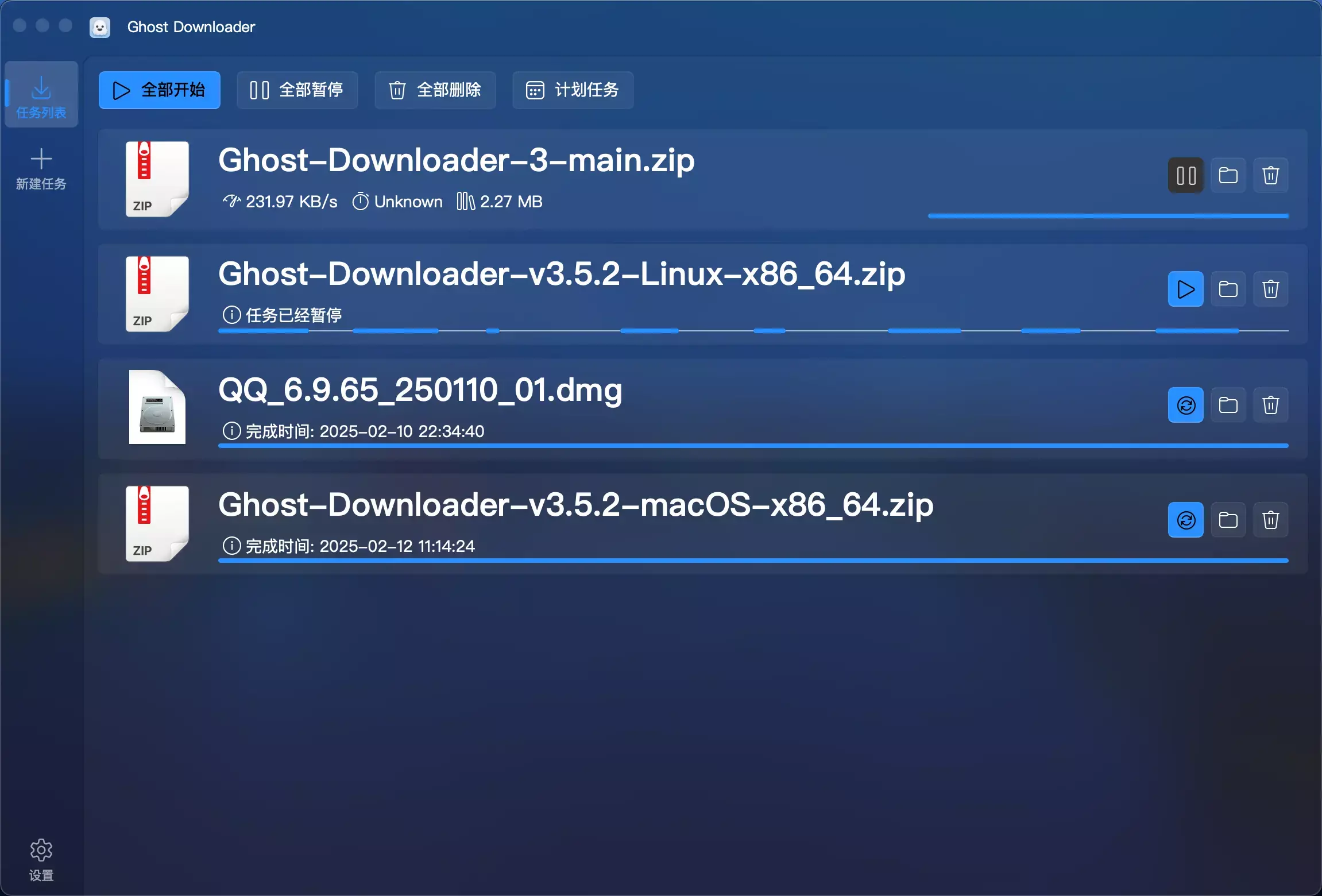

步骤四:优化体验——安装Chatbox AI

若你希望有更直观的对话界面,可以安装Chatbox AI,它将为你提供一个更友好的可视化界面,方便与DeepSeek进行交流。

前往Chatbox AI官网,下载并安装该应用。

打开Chatbox AI,选择Olama作为模型提供商,选择已安装的DeepSeek模型。

完成配置后,即可享受流畅的本地对话体验。

本地部署的设备要求

本地部署不仅限于台式电脑,笔记本电脑同样可以完成部署。具体配置要求可参考以下标准:

本地部署后的应用场景

AI编程助手:将DeepSeek集成到编程工具中,作为私人AI编程助手,提升开发效率。

自动化工具开发:可以基于DeepSeek构建定制化的自动化工具,提升工作流程的自动化程度。

私人智库:利用DeepSeek强大的推理能力,构建属于自己的知识库系统,随时提取所需信息。

最重要的是,本地部署无需网络连接,不受服务器限制,完全免费。

总结

通过简单的几步,你即可实现DeepSeek的本地化部署。

无需担心服务器繁忙或数据隐私问题,同时能够享受高效稳定的使用体验。

如果你有更高的需求,或者想要更深入地定制DeepSeek模型,本地部署无疑是一个强大的解决方案。

立即动手,体验本地化DeepSeek的无限可能!

评论前必须登录!

立即登录 注册